无线大数据(H3C WA1.0)历史数据迁移方案

- 0关注

- 0收藏 1122浏览

无线大数据(H3C WA1.0版本)系统现阶段没有平滑升级方案,而且存在历史版本过多的情况。所以,针对使用WA 1.0版本之前版本的局点,涉及需要无线大数据系统迁移时,需要在新的集群部署WA 1.0版本的无线大数据软件,同时,如果客户要求保留历史数据,需要参考本案例进行历史数据迁移。

无线大数据采集的数据主要是AP的设备在线信息和上网认证数据,分别保存在HDFS和HBase中,所以,历史数据迁移主要是迁移HDFS和HBase中的数据。

在恢复这两项数据之前请先查看新环境中的HBase是否正常初始化:

l 查看HBase中的存在的数据表

hbase shell->list即可查看hbase中的表,需要有如下5张表:

l 查看wirelessbigdata表空间下表的结构

describe ‘wirelessbigdata:表名’查看表结构。除了endpoint_sta_info(有两个列族),其他4张表都只有一个列族。

如果按照上述方法检查后发现HBase没有正常初始化,请使用如下步骤初始化Hbase:

l 建立新数据库:

create_namespace ‘wirelessbigdata',建立名为wirelessbigdata的表空间。

l 创建数据表

create 'tablename',{NAME=>'n1'},{NAME=>'n2'}……. ,{NAME=>'nn'}) 在wirelessbigdata下建立表,n1,n2为列族,视具体情况而定。(如果Hbase中数据表存在,但是列族有问题,需要先删除错误的数据表)

1、数据备份、恢复

之后备份恢复均使用表zone_sta_info为例子。

1.1 数据备份:

使用su hdfs切换到hdfs用户进行数据备份。进入hdfs用户后输入hbase org.apache.hadoop.hbase.mapreduce.Driver export wirelessbigdata:zone_sta_info /backup/zone_sta_info。

(/backup/zone_sta_info为备份到hdfs的地址,可以自定,但是不要使用wirelessdata)。

导出成功后使用hadoop dfs –ls /backup/zone_sta_info可以查看备份文件。

zone_sta_info已成功备份到hdfs,之后需再从hdfs到本地,请参考下一节hdfs备份。

1.2 数据备份的备用方法:

如HBase某张表过大无或者其他原因导致的数据导出的job不执行,可以使用如下备用方法

su hdfs->hdfs dfs –ls /apps/hbase/data/data/wirelessbigdata/表名/,可以看到数据分片。

hdfs dfs –get /apps/hbase/data/data/wirelessbigdata/表名/分片名 /tmp/xx,(tmp/xx为本地文件夹,需要事先建立),用get命令将所有hdfs中的数据分片复制到本地目录下。之后将所有分片拷贝到新节点上,在新节点上执行hdfs dfs –copyFromLocal /tmp/xx /apps/hbase/data/data/wirelessbigdata/表名/(注意上文,先建立数据库和表)。将所有分片导入到hdfs之后,exit。

su hbase->hbase hbck –repair,由于导入分片之后会产生不一致,所以请使用hbase用户进行repair。

之后,查看表状态为okay即可,进入hbase shell使用scan可以看到表中数据。

1.3 数据恢复:

注意两点:第一,在导入前,要确保HBase中有同名表,否则导入时会提示“找不到表“;第二,同名表的列族也需要和历史数据的列族相同。

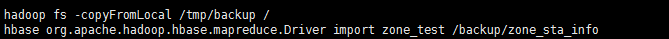

我们首先将之前备份的文件放入新节点的tmp目录下,su HDFS 切换到HDFS用户,并使用hadoop fs -copyFromLocal /tmp/backup /导入hdfs中(详见下一节HDFS文件恢复)。

然后,输入hbase org.apache.hadoop.hbase.mapreduce.Driver import wirelessbigdata:zone_sta_info /backup/zone_sta_info从HDFS中将恢复HBase的表数据。

完成后进入hbase shell->scan ‘table’查看表 zone_sta_info。

2、数据备份、恢复

2.1 文件备份:

使用Xshell连接至HDFS数据所在节点,使用root用户登录,键入hadoop dfs –ls /wirelessdata即可查看HDFS中的数据。

如上图我们可以看到HDFS中的数据,我们可以键入hadoop fs -get /wirelessdata /tmp拷贝数据到本地的tmp文件夹。(下图是将数据拷贝到root目录,不推荐这么做,因为root存在权限问题可能会导致失败)

如上图我们可以看到HDFS中的数据,我们可以键入hadoop fs -get /wirelessdata /tmp拷贝数据到本地的tmp文件夹。(下图是将数据拷贝到root目录,不推荐这么做,因为root存在权限问题可能会导致失败)

之后我们查看tmp目录,可以看到目录下有之前我们从HDFS拷贝的wirelessdata文件夹,文件夹中有需要备份的.csv文件。

2.2 文件恢复

我们将前文放入tmp文件夹下的wirelessdata拷贝到物理机上(例子中改名为wirelessdata2,应使用wirelessdata),用Xftp从物理机拷贝到新节点tmp文件夹下,使用命令hadoop fs -copyFromLocal /tmp/wirelessdata2 /,即可将备份的本地数据导入到HDFS。

该案例暂时没有网友评论

编辑评论

✖

案例意见反馈

亲~登录后才可以操作哦!

确定你的邮箱还未认证,请认证邮箱或绑定手机后进行当前操作